Viel Aufmerksamkeit für Existential Risks: UN-Bericht und offene Briefe von Wissenschaftler:innen

Das Thema existential risks und vor allem autonome Waffen haben in den vergangenen Wochen und Monaten auffallend viel Aufmerksamkeit bekommen. Im September etwa wurde von den Vereinten Nationen ein Bericht namens „Our Common Agenda“ veröffentlicht, in dem nicht nur mehrfach explizit von existential risks die Rede ist, sondern auch (mehr oder weniger) konkrete Vorschläge gemacht werden, wie wir existenziellen Risiken begegnen sollten – etwa mit einer Art Notfall-Plattform für komplexe globale Krisen, bestehend aus UNO-Vertreter:innen, Staats- und Regierungschef:innen von UN-Mitgliedsstaaten und anderen wichtigen Stakeholdern. Als Beispiele für existential risks werden unter anderem Cyberangriffe auf wichtige Infrastruktur, Atomunfälle, große Umweltkatastrophen oder technologische Entwicklungen, die in die falsche Richtung gehen, angesehen.

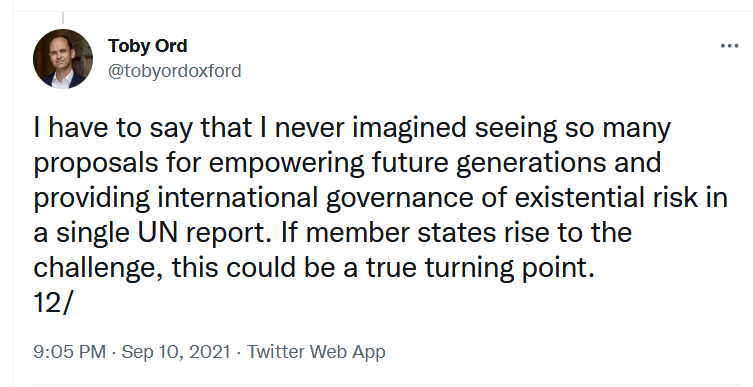

Aus EA-Sicht scheint der Bericht etwas ambivalent: einerseits ist es erfreulich, dass diesem oft vernachlässigten Thema ein ganzer UN-Bericht gewidmet wird. Auch Toby Ord, vielen durch sein Buch „The Precipice“ gut bekannt, freut sich darüber:

Andererseits ist die internationale Diplomatie freilich auch dafür bekannt, gesteckte Ziele oft erst spät oder gar nicht zu erreichen. Es wird sich also erst in einigen Jahren zeigen, inwiefern die Vereinten Nationen im Bereich existential risks tatsächlich etwas bewegen können.

Zur Gefahr autonomer Waffen

Unter den im Bericht angesprochenen Risiken sind jedenfalls auch autonome Waffen. Und hierzu wurden zuletzt gleich zwei offene Briefe veröffentlicht. Erstens haben führende Wissenschaftler:innen aus der KI-Forschung und Informatik (die meisten davon aus Deutschland, einige aber auch aus Österreich) am 1. November die deutschen Parteien SPD, Grüne und FDP aufgefordert, in einem möglichen Koalitionsvertrag die Bewaffnung von Drohnen für die Bundeswehr zu stoppen. Generell sprechen sie sich gegen autonome Waffensysteme aus, wörtlich heißt es:

„Die Tötung von Menschen sollte niemals aufgrund algorithmischer Formeln automatisiert ablaufen. Eine solche Entmenschlichung der Entscheidung über Leben und Tod durch autonome Waffensysteme muss weltweit geächtet werden! (…) Die Bewaffnung von Drohnen macht eine autonome Waffenführung prinzipiell möglich und stellt einen kritischen Wendepunkt dar. Der wissenschaftlich-technologische Stand ist mittlerweile so weit fortgeschritten, dass jede moderne ferngelenkte bewaffnete Drohne nur ein Software-Update von einer vollautonomen tödlichen Waffe entfernt ist, ohne dass dies nachgewiesen werden kann! Bewaffnete Drohnen müssen jetzt vermieden werden, bevor der Entwicklung hin zu vollautonomen Waffen kein Einhalt mehr geboten werden kann. Im öffentlichen Diskurs über die Bewaffnung von Drohnen wird die Gefahr einer schleichenden Automatisierung der Kriegsführung bisher unzureichend reflektiert – diese Debatte muss geführt werden! Denn mit der Bewaffnung von Drohnen wird eine kritische Schwelle zur Automatisierung der Kriegsführung überschritten: hin zur Entwicklung von Waffen, deren Angriff auf Menschen automatisiert abläuft, ohne weitere menschliche Entscheidung, Aufsicht oder Möglichkeit eines Abbruchs.“

Den gesamten Brief und die Liste der Unterzeichner findet man hier.

In einem zweiten offenen Brief, am 1. November in der „Frankfurter Allgemeinen Zeitung“ erschienen, wenden sich ebenfalls zahlreiche KI-Forscher:innen (die meisten davon aus Deutschland) an die drei deutschen Parteien, die derzeit über eine Koalition verhandeln. Unter anderem heißt es darin: „Entscheidungen über Leben und Tod dürfen nicht an Algorithmen delegiert werden. Der unregulierte Einsatz autonomer Waffensysteme stellt eine ernsthafte Gefährdung für das Völkerrecht sowie die Menschenrechte und vor allem die Menschenwürde dar.“ Für autonome Waffen brauche es deshalb einen rechtsverbindlichen internationalen Regulierungsrahmen, der autonome Waffen, die sich gezielt gegen Menschen richten oder bei denen echte menschliche Kontrolle nicht garantiert werden kann, verbietet. Deutschland müsse hier eine führende Rolle übernehmen. Hier gibt es den gesamten Brief zum Nachlesen.

Autonome Waffen sind keine ferne Dystopie

Noch wissen wir nicht, wie die nächste deutsche Regierung und Regierungen auf der ganzen Welt künftig mit dem Thema autonome Waffen umgehen werden. Klar ist aber (und das wird im ersten der beiden Briefe auch angesprochen), dass autonome Waffen keine ferne Dystopie sind. Das zeigen auch zwei US-Firmen, die Roboterhunden Maschinengewehre umgeschnallt haben, wie das US-Technikportal „The Verge“ berichtet. Konkret wurde der von Ghost Robotics entwickelte Roboter „Vision 60“ von der Waffenschmiede Sword International mit einem Maschinengewehr ausgestattet, das nicht nur eine Reichweite von 1200 Metern, sondern auch einen 30-fachen optischen Zoom und eine Wärmebildkamera hat. Gezeigt wurde das „Gewehr auf vier Beinen“ erstmals im Oktober auf der jährlichen Konferenz einer Interessenvertretung der United States Army in Washington DC.

Fotocredit: Sword International

Rund um diesen doch einigermaßen besorgniserregenden Roboter sind noch einige Fragen offen. So ist etwa unklar, ob und wann er verkauft wird. Auch die Zielgruppe des Robotergewehrs wird offiziell nicht genannt. Außerdem ist nicht klar, welche Rolle menschliche Entscheidungen beim Einsatz von „Vision 60“ spielen sollen. „The Verge“ schreibt allerdings, dass Roboterhunde von Ghost Robotics voriges Jahr schon von einer Spezialeinheit des US-Militärs getestet wurden – etwa um die Grenzen einer Militärbasis zu überwachen. Und in der Zukunft könnten sie eben auch zu Waffen werden. Denn auch wenn Boston Dynamics (die bekannteste US-Firma, die u.a. Roboterhunde herstellt) strikt gegen das Bewaffnen von Maschinen ist, so sind andere Hersteller hier offensichtlich weniger streng. Immerhin erlauben die Gesetze in den USA die Entwicklung und den Verkauf dieser „Killer-Roboter“. Sofern diese Entwicklung also nicht seitens der Politik gestoppt wird, können und werden manche Firmen etwa Roboterhunde mit Waffen ausstatten. Und das zeigt wiederum, warum die Themen existential risks und autonome Waffen so wichtig sind.